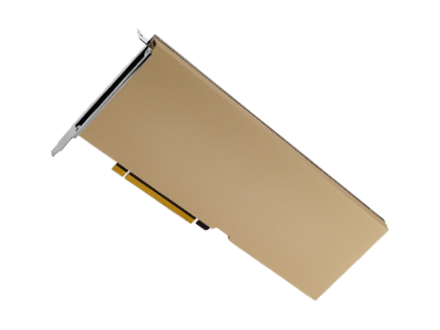

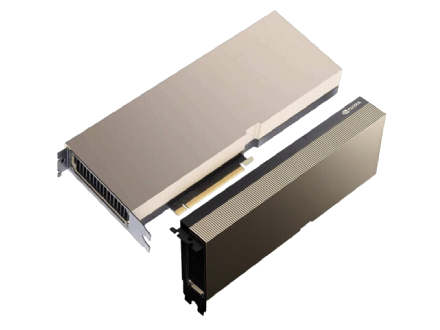

英伟达Tesla A30 24G深度学习加速显卡

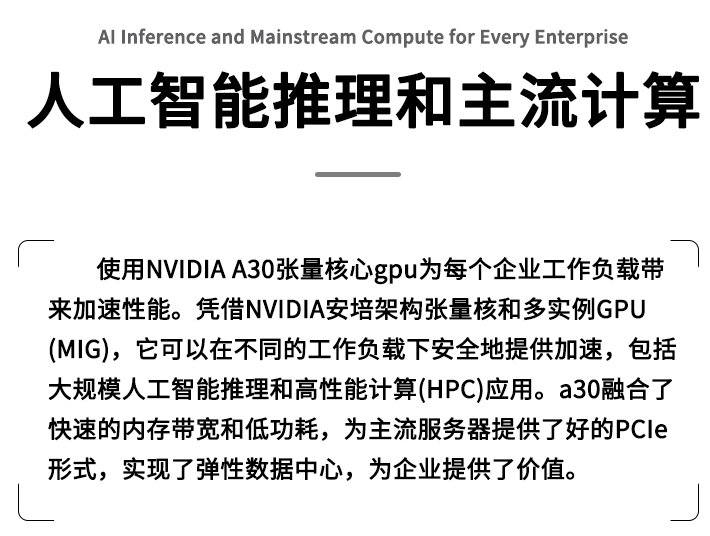

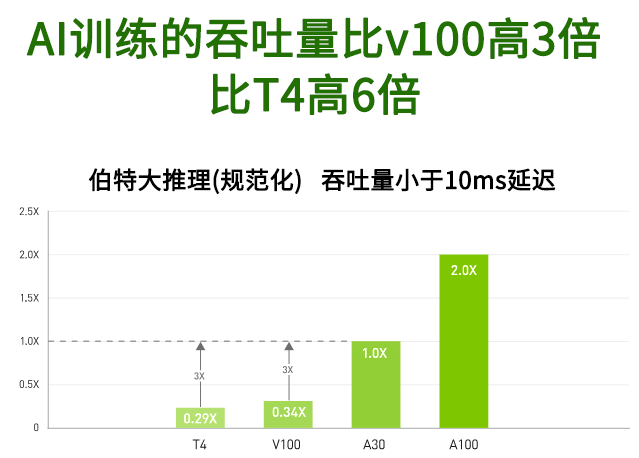

企业级的A30支持广泛的AI推理、人工智能和传统的企业计算工作负载。它可以为AI应用提供支持,例如推荐系统,对话式AI和计算机视觉系统。在人工智能方面,第三代NVIDIA Tensor Core支持单精度浮点计算和创新的数学模式TensorFloat-32,与上一代NVIDIA T4 GPU相比,性能提高了20倍。

- 毛重:1.0kg

- 质保期:3年质保

- 显存类型:GDDR6

- 显存: 24 GB HBM2

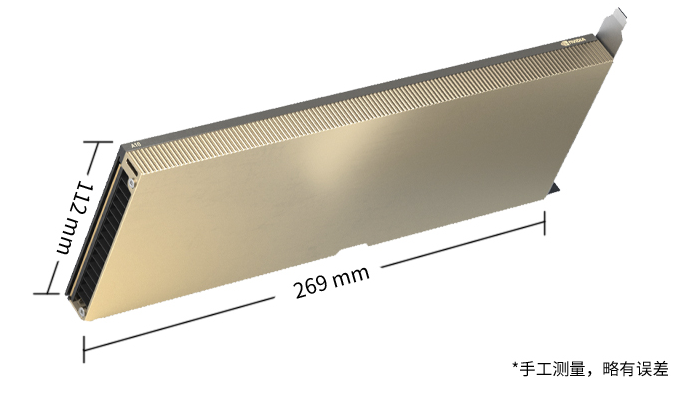

- 尺寸:170*79*30

- 参考价格:34000元

- 采购报价联系:18681551725